EfficientNet: Rethinking Model Scaling for Convolutional Neural Networks (ICML2019)

前言

- 這篇也主要是處理一些類似 overparameterized 的問題,怎麼在 network 的 depth/width/resolution 做取捨,概念如下圖,如何在三者之間取得一個平衡是本篇的重點。

- 效果如下

方法及實驗

- 透過將每個 layer 乘上一個固定比例的常數,然後去最大化 accuracy。

- 這篇的 baseline network

- 改變 width/depth/resolution 的影響,雖然有明顯的成長但容易飽和,其中針對 width 會造成 shallow networks,沒辦法得到比較 high level 的資訊,增加 depth 才能得到比較 high level 的資訊,而跟 width 跟 resolution 一樣是屬於比較 fine-grained pattern(r = 224x224)。

- 而很直觀的三者之間其實會互相影響,比如增加 resolution 你不增加 kernel size 或是 depth 的話,receptive fields 會變小,下圖比較相同 FLOPS

- 此篇提出 compound scaling method,α/β/γ 是可透過 small grid search 找到的常數,φ 是 user-specified coefficient,其中增加兩倍 depth/width/resolution 會增加 2/4/4 倍的 FLOPS。

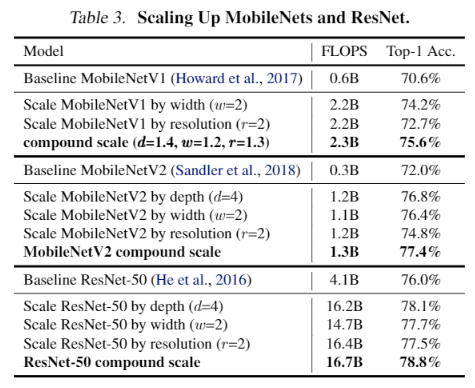

- 透過他們方法調整的 MobileNet 和 ResNet。

- 將 EfficientNet 訓練在 ImageNet 上的成果。

- 跑在 CPU 上測試 inference time 的時間。

- Pretrained 在 ImageNet 然後 Transfer learning 在不同 Dataset 的結果。

- 比較不同 Scaling 方式和此篇論文的 compound scaling。

- 滿有意義的一張圖,透過視覺化解釋了各種 scaling 所帶來的影響。

Reference

[arxiv]