360-Degree Gaze Estimation in the Wild Using Multiple Zoom Scales (BMVC 2021)

Introduction

台大林軒田實驗室出的論文,主要有兩個貢獻。

- 提出透過 Multiple scales 的方式解決 Gaze estimation in the wild 資料大小不一的問題,與 Baseline 相同不需要使用 Eye, head pose, facial keypoints 之類的資訊,只需要簡單的 Head detector。

- 透過 Polar representation 的方式預測 Backward yaw angle prediction 減輕球座標角度不連續的問題。

Method

- 利用現有的 Head detector 得到 Head-crop image (I),Input 一段影像,輸出每個 Frame 的 yaw(θ_p) 和 pitch(Φ_p),θ 和 Φ 為球座標系的 yaw 和 pitch,下標 _p = predict, _g = ground truth。

- 但因為球座標系在正後方是 π 和 -π 交界的地方會導致不連續的問題,因此此篇改預測 sin(θ){θ_s}, cos(θ){θ_c}, and sin(Φ) 並用 tanh activation 保證輸出在合理的 Range。

- 作者認為 0 度左右的時候 θ_s 比較準,且因為 tanh 分布的關係會導致很難預測 0 度和 +- 90 度左右的值,因此另外用下面的方式計算 Weight。

- Loss 的部分和 Baseline model(Gaze360) 一樣,σ = uncertainty, τ = quantile,σ 是模型輸出的一個 probability,這邊的概念和這篇論文的 Reliable output 的概念也很像,τ 設定為 0.1 和 0.9,最後的 Loss 是兩者計算完的平均。

- Input sequence 從第一幀影像原本的 Size(C_0) 依序 Crop 越大直到 C_T,使得臉部範圍越大,然後再依序回到原本的 Size(C_0),讓輸入能有不同 Scale 的影像,之後再丟到 MSA,實驗設定 T = 3,Crop 大小分別為 [224,200,175,150]。

- MSA 的部分就是 Backbone 加上對不同 Scale 的 Feature 做 Max-pooling 之後進行 Predict。

Experiment

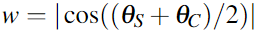

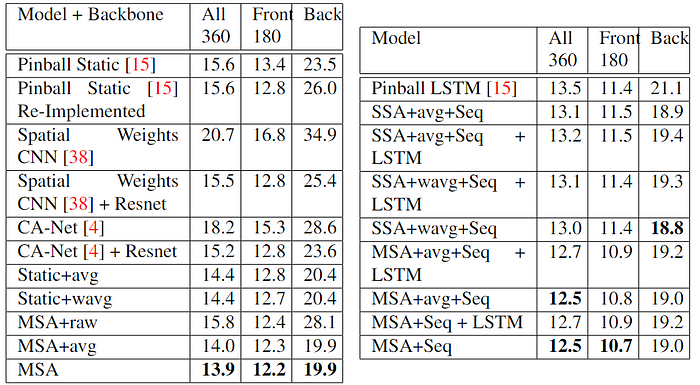

Backbone 為 Resnet18,Static 表示沒用 Multi-crop,SSA 是沒有 Multi-crop 的 MSA,raw 表示直接預測 θ,avg 是直接平均 θ_s 和 θ_c。

Reference

[arxiv]